Séminaire Avancé en Imagerie du Petit Animal S3

Le réseau SAIN (Small Animal Imaging Network), qui regroupe au niveau national des scientifiques impliqués dans l’imagerie du petit animal, organise des Séminaires Avancés en Imagerie in vivo du Petit Animal (SAIPAs).

Les SAIPAs sont constitués de webinaires qui se succèderont sur trois thèmes :

S1 : Développement de séquences avancées d’acquisition d’image IRM. Responsables : Emeline Ribot & Aurélien Trottier (RMSB, Bordeaux), Denis Grenier (Creatis, Lyon) + un correspondant Bruker.

S2 : Prétraitement et visualisation des images. Responsables : Benjamin Lemasson (GIN, Grenoble), Sébastien Mériaux (NeuroSpin, Saclay), Sorina Pop (Créatis Lyon).

S3 : Méthodes d’analyse à base d’apprentissage machine. Responsables : Benjamin Lemasson (GIN, Grenoble), Vincent Noblet (Icube, Strabourg), Sorina Pop (Créatis Lyon).

Le public visé est les étudiants et chercheurs impliqués dans des projets reposant sur l’imagerie petit animal et intéressés par les techniques avancées d’acquisition de traitement et d’analyse de ces images.

Les objectifs des SAIPAs sont multiple : valoriser et diffuser l’expertise des membres du groupe SAIN, former les chercheurs aux techniques avancées dans le domaine de l’imagerie in vivo du petit animal et sensibiliser les participants au partage de données et d’outils dans ce domaine (respect de la politique des 3R, open data, traçabilité des traitements). Les SAIPAs bénéficieront de l’infrastructure FLI-IAM pour la gestion des données et l’exécution des pipelines.

Ce premier webinaire de la thématique S3: Méthodes d’analyse à base d’apprentissage machine, est

prévu le 10 Novembre 2022 (détail ci-dessous).

Ce webinaire a pour objectif de montrer, à travers des TP interactifs, l’utilisation de différents réseaux de neurones convolutionnels appliqués à des données d’imagerie IRM préclinique. Ce web-séminaire s’articulera autour de deux cas d’usages : i) la correction d’artefacts et ii) la classification d’images.

Descriptif : Présentation et prise en main de MONAI [1] , un environnement de développement sous python d’algorithmes d’intelligence artificielle, à travers deux cas pratiques sur des données IRM préclinique : i) la correction d’artefacts et ii) la classification d’images.

Correction d’artefacts :

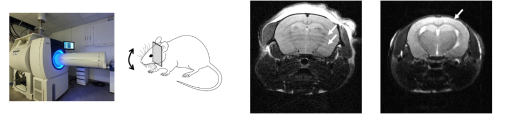

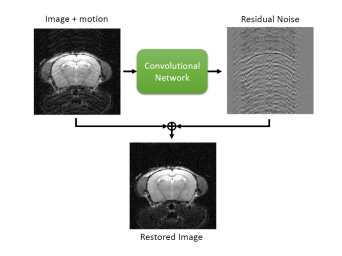

Les artefacts de mouvements sont une problématique récurrente en IRM et peuvent se manifester sur les images reconstruites de différentes manières. Pour ce TP, nous travaillerons sur les artefacts visibles en imagerie cérébrale qui sont le plus souvent liés aux mouvements respiratoires des animaux dont la tête n’est pas correctement fixée dans le berceau :

Nous verrons comment simuler ces artefacts de mouvements afin de créer un large ensemble de données permettant d’entraîner un réseau de neurones convolutionnel basé sur l’apprentissage des résidus entre l’image artéfactée et l’image dépourvue d’artefact [2]. L’objectif de ce TP est ainsi de montrer comment nous pouvons utiliser les réseaux de neurones convolutionnels pour générer des images corrigées à partir d’images contenant des artefacts de mouvements.

Classification d’images :

La classification d’images est l’une des tâches les plus courantes réalisée par des réseaux de neurones. Dans ce second cas pratique, nous prendrons en main les outils nécessaires à l’entraînement d’un réseau de neurones convolutionnel capable de détecter automatiquement la présence d’une tumeur cérébrale ou d’un AVC à partir d’images IRM multiparamétrique chez le rat. Ce TP sera l’occasion de passer en revue les différents hyperparamètres d’un réseau de neurones convolutionnel ainsi que l’augmentation de données indispensables à leur entraînement. Pour finir, nous présenterons une méthode appelée “Grad-CAM” qui permet de visualiser les parties de l’image les plus importantes pour sa classification [3]

Volume horaire : 1/2 journée (10 Novembre 2022 ; 13h30-17h30)

Prérequis : Étant donné que nous utiliserons l’environnement Google pour i) partager les jeux de données d’imageries et ii) exécuter des notebooks sur Google Colab, vous aurez besoin d’un compte Google et de Google Chrome installés sur votre ordinateur. Si vous n’avez pas de compte Google (ou que vous ne souhaitez pas communiquer votre email personnel), vous pouvez facilement créer un compte dédié à ce séminaire. Une connaissance de Python est un plus, mais n’est pas indispensable. Les personnes qui souhaitent se familiariser avec l’environnement MONAI avant ce webinar peuvent le faire via ces tutoriels disponibles sur le Github de MONAI [4-5].

Inscription : https://survey.creatis.insa-lyon.fr/index.php/356311?lang=fr

Présentateurs/organisateurs :

Benjamin Lemasson (CR, Inserm, GIN, Grenoble),

Mikaël Naveau (IR, Cyceron, Caen)

Vincent Noblet (IR, CNRS, ICube, Strasbourg)

Sorina Pop (IR, CNRS, Creatis, Lyon)

Franck Valentini (Doctorant, Université de Strasbourg, ICube, Strasbourg),

Références :

[1] https://monai.io/

[2] Beyong a Gaussian Denoiser : Residual Learning of Deep CNN for Image Denoising, Zhang et al.,

2016

[3] Grad-CAM: Visual Explanations from Deep Networks via: Gradient-based Localization. R. R.

Selvaraju et al. IEEE; 2017

[4] https://github.com/Project-MONAI/tutorials/blob/main/3d_classification/densenet_training_a

rray.ipynb

[5] https://github.com/Project-MONAI/tutorials/blob/main/3d_segmentation/swin_unetr_brats21

FLI

FLI